CRITERIOS PARA UNA BUENA EVALUACIÓN.

La evaluación educativa es tan buena como la metodología utilizada y el uso que se hace de los resultados.

Varias organizaciones internacionales han propuesto criterios sobre las “buenas prácticas” en evaluación (American Educational Research Association [AERA], American Psychological Assocation [APA] y National Council on Measurement in Education [NCME], 2014; Norcini et al., 2011). Estos criterios son: validez, confiabilidad, justicia, equivalencia, factibilidad, efecto educativo y aceptabilidad.

Validez

Uno de los conceptos más importantes para que los resultados de los procesos de evaluación tengan sustento sólido y uso apropiado es el de validez. La validez de un proceso de evaluación es el grado con el que mide lo que se supone que mide. La validez es un concepto unitario, y actualmente se considera que toda la validez es validez de constructo (AERA, APA y NCME, 2014; Downing, 2003; Kane, 2013). La palabra constructo significa colecciones de conceptos abstractos y principios, inferidos de la conducta y explicados por una teoría educativa o psicológica, es decir, atributos o características que no pueden observarse directamente (por ejemplo: inteligencia, timidez, conocimientos sobre química) (Brennan, 2006; Downing, 2003).

Validez es un juicio valorativo holístico e integrador que requiere múltiples fuentes de evidencia para la interpretación del constructo evaluado, ya que intenta responder a la pregunta “¿qué inferencias pueden hacerse sobre la persona basándose en los resultados del examen?” (Downing, 2003; Mendoza Ramos, 2015). No es el examen el que es válido per se, ya que la validez de un examen es específica para un propósito, se refiere, más bien, a lo apropiado de la interpretación de los resultados. En otras palabras, la validez no es una propiedad intrínseca de los exámenes, sino del significado de los resultados en el entorno educativo específico y las inferencias que pueden hacerse de los mismos. Por ejemplo, los resultados de los médicos que sustentan el examen para ingresar a las residencias médicas (ENARM), no deben interpretarse como evidencia de la calidad de las escuelas de medicina de donde provienen, ya que el examen no está diseñado con ese propósito.

Las cinco fuentes importantes de validez en evaluación del aprendizaje son (AERA, APA y NCME, 2014; Downing, 2003):

- Contenido. Debe utilizarse una tabla de especificaciones de la prueba y el proceso seguido para elaborarla, la definición de los temas, la congruencia del contenido de las preguntas con las especificaciones del examen, la representatividad de las preguntas de las diferentes áreas a examinar, la calidad de las preguntas, las credenciales de las personas que elaboran las preguntas, entre otros.

- Procesos de respuesta. Se requiere evidencia de integridad de los datos, de manera que las fuentes de error que se pueden asociar con la administración del examen hayan sido controladas en la medida de lo posible. Por ejemplo, el control de calidad de la elaboración del examen, la validación de la clave de la hoja de respuestas utilizada, el control de calidad del reporte de los resultados del examen, la familiaridad del estudiante con el formato de evaluación (lápiz y papel o computadora).

- Estructura interna. Se refiere a las características estadísticas del examen y de las preguntas que lo componen, como son el análisis estadístico de reactivos, el funcionamiento de los distractores en las preguntas de opción múltiple, la confiabilidad del examen, entre otros. Muchos de estos datos debieran obtenerse de rutina como parte del proceso de control de calidad del examen, principalmente en los exámenes de alto impacto.

- Relación con otras variables. La relación de los resultados en el examen con otras variables se refiere a la correlación estadística entre los resultados obtenidos por medio de una prueba con otra medición de características conocidas. Por ejemplo, la correlación entre el examen de admisión a la licenciatura y las calificaciones obtenidas en los exámenes parciales durante la carrera y el examen profesional.

- Consecuencias. Se refiere al impacto en los estudiantes de las puntuaciones de la evaluación, de las decisiones que se toman como resultado del examen, y su efecto en la enseñanza y el aprendizaje. Por ejemplo, el método de establecimiento del punto de corte para aprobar o reprobar un examen, las consecuencias para el estudiante y la sociedad, las consecuencias para los profesores y las instituciones educativas.

Validez implica una aproximación científica a la interpretación de los resultados de los exámenes, es decir, probar hipótesis sobre los conceptos evaluados en el examen. La información proporcionada por un instrumento de evaluación no es válida o inválida, sino que los resultados del examen tienen más o menos evidencia de las diferentes fuentes para apoyar o rechazar una interpretación específica (por ejemplo, pasar o reprobar un curso, certificar o no a un especialista, admitir o no a un estudiante en la universidad) (Downing, 2003; Kane, 2013). Las organizaciones que elaboran e implementan el examen (entidades gubernamentales, instituciones educativas, consejos de certificación) son los candidatos obvios para validar las afirmaciones que hacen sobre la interpretación de los resultados de un examen, ya que generalmente son quienes tienen los elementos y recursos para hacerlo (Brennan, 2006). Quienes elaboramos exámenes tenemos la obligación ética y el imperativo educativo de documentar qué tan defendible es la interpretación de los resultados, en beneficio de los estudiantes y de la sociedad en general.

Confiabilidad

La confiabilidad o fiabilidad tiene un significado técnico en evaluación educativa, que no debe confundirse con el significado coloquial de la palabra. La confiabilidad de un examen se refiere a la consistencia de las puntuaciones obtenidas por las mismas personas en ocasiones diferentes o con diferentes conjuntos de preguntas equivalentes, es decir, la reproducibilidad de la prueba (Downing, 2004). Es un concepto estadístico, que representa el grado en el cual las puntuaciones de los alumnos serían similares si fueran examinados de nuevo. Generalmente se expresa como un coeficiente de correlación, siendo 1.0 una correlación perfecta y cero ninguna correlación. Mientras más alta es la cifra de confiabilidad, generalmente es mayor su peso como evidencia de validez. La cifra de confiabilidad suficiente para aceptar los resultados de un proceso de evaluación depende del propósito de la misma, el uso que se hará de los resultados del examen y de las consecuencias que tendrá la evaluación sobre los estudiantes.

Para exámenes de muy alto impacto, la confiabilidad debe ser alta para que las inferencias de los resultados del examen sean defendibles. Varios expertos recomiendan una confiabilidad de por lo menos 0.90 para evaluaciones de muy altas consecuencias. Para exámenes de consecuencias moderadas, como las evaluaciones sumativas de fin de curso en la escuela, es deseable que la confiabilidad sea de 0.80 a 0.89. En exámenes de menores consecuencias, como la evaluación formativa o exámenes parciales diagnósticos, es aceptable una confiabilidad de 0.70 a 0.79. Estas cifras no representan rangos absolutos, ya que hay diferencias de opinión entre los expertos, pero pueden servir de marco de referencia (Downing, 2004).

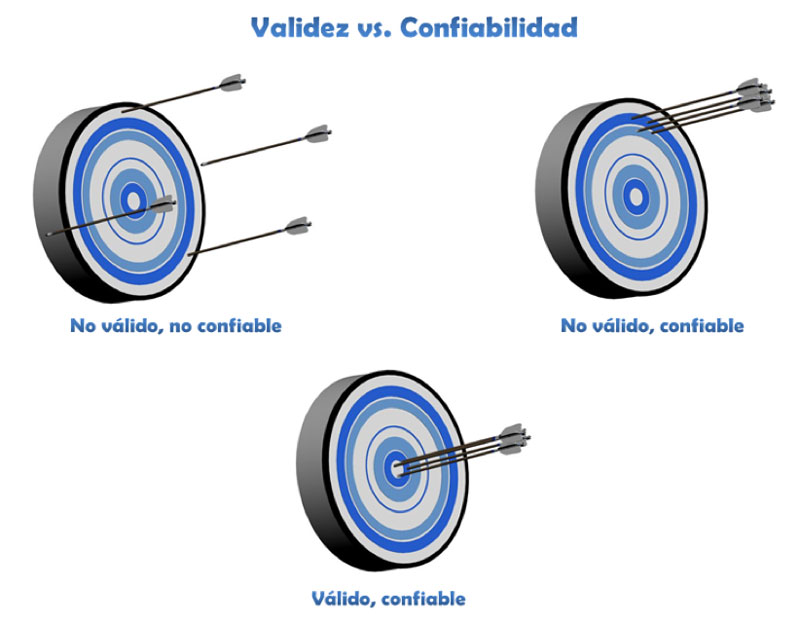

La confiabilidad de una medición es necesaria para obtener resultados válidos, aunque puede haber resultados confiables sin validez (es decir, la confiabilidad es necesaria, pero no suficiente para la validez). La analogía con la diana de un blanco de tiro es útil para entender la relación entre los dos conceptos, como se muestra en la figura 1. Si las flechas están muy dispersas entre sí y lejos de la diana, la medición es poco confiable y no es válida; si las flechas están muy juntas pero lejos del centro la medición es reproducible (confiable) pero no es válida; y si las flechas están juntas en la diana, la medición es confiable y válida.

Figura 1. Esquema visual de los conceptos de validez y confiabilidad, con el símil de un blanco de tiro.

Justicia y equidad

En las últimas décadas las principales organizaciones de evaluación educativa del mundo han hecho mucho énfasis en la necesidad de justicia y equidad en todo el proceso educativo, incluyendo la evaluación del aprendizaje, para ser congruentes con el sentido social de la educación (AERA, APA y NCME, 2014; Instituto Nacional para la Evaluación de la Educación [INEE], 2017). Existe controversia sobre el tema, ya que los exámenes estandarizados en gran escala –que por necesidad se aplican y analizan en contextos altamente controlados para que cada estudiante se enfrente al mismo reto en igualdad de condiciones–, por definición, tratan a todos los estudiantes de la misma manera. Si queremos promover la evaluación formativa para el aprendizaje, deberíamos individualizar el uso de los instrumentos de evaluación para cada caso específico. Esta permanente tensión entre lo ideal y lo real continúa sin resolverse. Podríamos ampliar el abanico de estrategias de evaluación educativa que utilizamos en la práctica, y capacitar a los profesores en el uso de diversos instrumentos de evaluación para promover el aprendizaje a lo largo del proceso.

Equivalencia

La equivalencia se refiere a que los exámenes proporcionen puntuaciones o decisiones equivalentes, cuando se administran en diferentes lugares o tiempos (AERA, APA y NCME, 2014; Norcini et al., 2011). La mayoría de los docentes y estudiantes no conocemos este concepto, a pesar de su importancia para interpretar exámenes aplicados de manera periódica que pretenden evaluar lo mismo, o exámenes en diferentes contextos en los que queremos asegurar que sean de la misma dificultad, sobre todo en evaluación sumativa de alto impacto (Carter, 1984; Moreno Olivos, 2010). Para lograr equivalencia se requiere de procedimientos estadísticos sofisticados, que caen en la familia de métodos de equiparación o “igualación” de exámenes. Uno de estos métodos es el uso de “reactivos ancla” (preguntas con un grado de dificultad similar y comportamiento estadístico bien documentado) en un porcentaje de reactivos de cada versión del examen. Para estas técnicas se requieren profesionales en dichos procedimientos.

Factibilidad y aceptabilidad

Las evaluaciones deben ser prácticas, realistas y apropiadas a las circunstancias del contexto, incluyendo las instalaciones físicas y los recursos humanos y financieros disponibles. Por ejemplo, el método más utilizado en el mundo para evaluar la competencia clínica en medicina es el Examen Clínico Objetivo Estructurado (ECOE), que consiste en una serie de múltiples estaciones estandarizadas, en las que cada estudiante se enfrenta a un reto que requiere que aplique algunas competencias específicas, como pueden ser las habilidades de comunicación, el hacer un diagnóstico, o interpretar radiografías y estudios de laboratorio (Boursicot et al., 2011). Este tipo de examen requiere gran cantidad de recursos humanos, instalaciones apropiadas y mucha dedicación en disciplina, tiempo y organización. Esta disponibilidad de recursos puede no estar al alcance de algunas escuelas, de manera que, aunque el examen sea excelente y se use en muchas partes del mundo, si no se puede hacer en una institución hay que buscar alternativas. Otros ejemplos podrían ser el uso de exámenes adaptativos por computadora, simuladores de alta fidelidad y tecnología de punta, herramientas que requieren una gran inversión inicial y de mantenimiento. Las evaluaciones también deben ser aceptables tanto por los estudiantes como por los profesores. Si hay un rechazo de la comunidad a algún tipo de evaluación –por ejemplo, la evaluación por pares que implica ser evaluado por sus compañeros–, se hace difícil su implementación.

Efecto educativo, efecto catalítico

Todos los métodos de evaluación, sobre todo los sumativos, pueden tener efectos en los métodos de estudio y prioridades de aprendizaje de los estudiantes (Newble, 1983). Aunque los profesores les digamos a nuestros alumnos que un tema o concepto es fundamental, la pregunta común es: “¿y eso va a venir en el examen?”. La cultura de algunas escuelas es que si algo no cuenta para el examen no se le da mucha importancia, así que la manera cómo se aplica la evaluación tiene consecuencias en la motivación de los estudiantes y en sus métodos de estudio. También la evaluación puede tener un efecto “catalítico” en el contexto educativo, ya que puede influir en los demás docentes, en los departamentos académicos y en la institución misma (Norcini et al., 2011). Si se privilegian los exámenes escritos de opción múltiple, habrá un efecto en cascada en los diferentes participantes del proceso educativo. Si se fomenta la evaluación formativa, de la misma manera, habrá influencia en las actitudes hacia la evaluación de los participantes, sobre todo cuando vivan sus efectos positivos.

Amenazas a la validez

Existen diversas “amenazas” para la validez de un proceso de evaluación del aprendizaje, que disminuyen la credibilidad de las inferencias que se pueden hacer de los resultados de un examen. Al ser la validez uno de los principales elementos de una buena evaluación, todo lo que ponga en riesgo la veracidad de las conclusiones que podamos tener sobre los resultados de una prueba o examen debe identificarse y, en la medida de lo posible, evitarse o corregirse. Pueden clasificarse de la siguiente manera (Downing y Haladyna, 2004):

- Infrarrepresentación del constructo (IC). Se refiere a una representación inapropiada del contenido a evaluar por los exámenes, teniendo en mente que el constructo es aquello que queremos investigar (como los conocimientos de química en el bachillerato). Son ejemplos de esta amenaza: muy pocas preguntas en el examen, que no exploren apropiadamente el área de conocimiento; uso de preguntas que exploren principalmente memoria o reconocimiento de datos, cuando las metas de la enseñanza son la aplicación o solución de problemas.

Otra amenaza a la validez es el fenómeno de “enseñando para la prueba” (teaching to the test, en inglés), en el que se enfatiza demasiado lo que va a venir en el examen, distorsionando el plan de estudios y el proceso educativo, y generando resultados incompletos que no preparan al estudiante para enfrentarse al ejercicio profesional (Popham, 2001). A veces ocurre al grado que algunos profesores utilizan reactivos del examen en clase para aumentar artificialmente las calificaciones de sus alumnos, y mejorar las evaluaciones de su grupo o escuela. - Varianza irrelevante al constructo (VIC). Se refiere a elementos que interfieren con la capacidad de interpretar los resultados de la evaluación de una manera significativa, y que causan “ruido” en la evaluación. Por ejemplo, las preguntas elaboradas con fallas, gramaticales o de otro tipo; y las que dan pistas al estudiante sobre cuál es la respuesta correcta, aunque no sepa el concepto explorado en la pregunta. Recordemos que escribir buenas preguntas de examen requiere entrenamiento y experiencia. Otro ejemplo son los problemas de seguridad del examen y fuga de información, de manera que el resultado del examen no refleja los conocimientos de los estudiantes. Este problema invalida los resultados de los exámenes, con diversas implicaciones éticas y de uso de recursos, como es repetir el examen con otra versión.

La “astucia” o habilidad para responder los exámenes (en inglés, testwiseness) ocurre cuando los estudiantes se preparan con estrategias para responder exámenes y pueden obtener puntajes que no reflejen lo que realmente saben. Se ha creado un mercado de organizaciones que dan cursos para pasar exámenes, en los que el objetivo es adiestrar a los asistentes en métodos para obtener la mayor puntuación posible. Las familias de los estudiantes pagan un precio alto por estos cursos, que son de efectividad cuestionable y que además promueven una competencia poco sana.

También te puede interesar

Esta web se reserva el derecho de suprimir, por cualquier razón y sin previo aviso, cualquier contenido generado en los espacios de participación en caso de que los mensajes incluyan insultos, mensajes racistas, sexistas... Tampoco se permitirán los ataques personales ni los comentarios que insistan en boicotear la labor informativa de la web, ni todos aquellos mensajes no relacionados con la noticia que se esté comentando. De no respetarse estas mínimas normas de participación este medio se verá obligado a prescindir de este foro, lamentándolo sinceramente por todos cuantos intervienen y hacen en todo momento un uso absolutamente cívico y respetuoso de la libertad de expresión.

No hay opiniones. Sé el primero en escribir.